srv.pid

notes/private

+content/images/private

A little bit of lipstick rubbed off on the sandwich and the straw.

-At the convention hotel, I waited in the lobby for a while, still with the jacket over my uniform, reading the Janet Mock autobiography on my PADD, until it was time to check in. After buying my Sunday wristband ($70), I wandered over to the photo-op/autograph ticketing table and bought a ticket to get a photo with Michael Dorn at 11:10 ($40). (Nana Visitor or Terry Farrell herself would have been my first choices for a celebrity photo, but they weren't there that day.)

+<a id="reading-the-janet-mock-autobiography"></a>At the convention hotel, I waited in the lobby for a while, still with the jacket over my uniform, reading the Janet Mock autobiography on my PADD, until it was time to check in. After buying my Sunday wristband ($70), I wandered over to the photo-op/autograph ticketing table and bought a ticket to get a photo with Michael Dorn at 11:10 ($40). (Nana Visitor or Terry Farrell herself would have been my first choices for a celebrity photo, but they weren't there that day.)

There was still a lot of time to hang out before the theater opened for the actual convention programming, but that was fine, because actual convention programming is kind of boring; the actual point of conventions is to have an excuse to dress up and wander around and talk to people and get vanity photos of other people who are using the convention as an excuse to dress up.

After de Lancie, there was a discussion with some writer-folk (the schedule _said_ the topic would be the [new series next year](https://en.wikipedia.org/wiki/Star_Trek:_Discovery), but they didn't seem to know anything about it), and soon enough, it was time for my photo op with Michael Dorn.

-The photo session was very assembly-line—here (unlike the autograph sessions I witnessed at other conventions) there was no pretense of your $40 giving you the opportunity to actually _meet_ your heroes for even half a minute: this was pose, _click_, and it's over, time for the next fan to get in position. I had time to say to Dorn, "I'm Jadzia," but that was it.

+<a id="photo-assembly-line"></a>The photo session was very assembly-line—here (unlike the autograph sessions I witnessed at other conventions) there was no pretense of your $40 giving you the opportunity to actually _meet_ your heroes for even half a minute: this was pose, _click_, and it's over, time for the next fan to get in position. I had time to say to Dorn, "I'm Jadzia," but that was it.

Not that I was disappointed. A woman on the event staff commented on how happy I looked skipping down the room after the photo was taken. "[My future husband!](http://memory-alpha.wikia.com/wiki/You_Are_Cordially_Invited_%28episode%29)" I said.

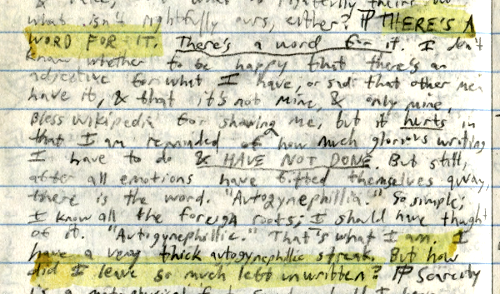

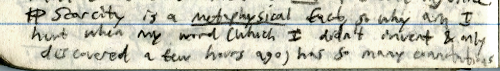

> THERE'S A WORD FOR IT. _There's a word for it._ I don't know whether to be happy that there's an adjective for what I have, or sad that other men have it, & that it's not mine, & only mine. Bless Wikipedia for showing me [...] But still, after all emotions have fitted themselves away, there is the word. "Autogynephilia." So simple; I know all the foreign roots; I should have thought of it. "Autogynephilic." That's what I am.

-

+

And:

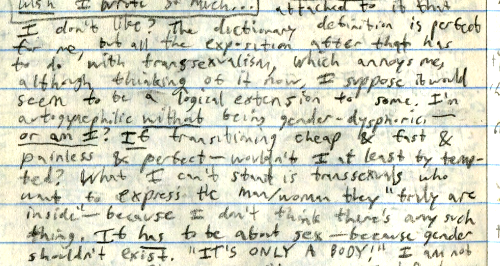

> Scarcity is a _metaphysical_ fact, so why am I hurt when my word (which I didn't invent & only discovered a few hours ago) has so many connotations attached to it that I don't like? The dictionary definition is perfect for me, but all the exposition after that has to do with transsexualism, which annoys me, although thinking of it now, I suppose it would seem to be a logical extension to some. I'm autogynephilic _without_ being gender-dysphoric—_or am I?_ _If_ transitioning cheap & fast & painless & perfect—wouldn't I at least be tempted? What I can't stand is transsexuals who want to express the man/woman they "truly are inside"—because I don't think there's any such thing. It _has_ to be about sex—because gender shouldn't exist.

-

+

-

+

<a id="views-have-changed"></a>My views on gender have changed a _lot_ over the past ten years—most notably, I'm not a psychological sex differences denialist anymore, so I'm afraid I can no longer endorse that "gender shouldn't exist" stance. (Given that sex differences exist and people aren't going to _pretend not to notice_, social-role defaults are inevitably going to accrete around them.)

I remember (and [the Diary entry](/ancillary/diary/296/) helps, too) there was a party/meetup at someone's place down in Sunnyvale, perhaps in honor of Robin being in town. This was a little less than nine years ago, back during the golden age when the Sequences were still being written, when the _M_ and _R_ in _MIRI_ were still an _S_ and an _A_, respectively—before the Eternal September, before everyone was poly, and _long_ before everyone was trans.

-I worked the 0600 to 1500 bookkeeper/customer-service shift at my supermarket dayjob that day. After work, I dropped off the week's bag of redeemed manufacturer's coupons at store #936 (what the company did with them after that, I was never told—perhaps they weighed them), bought a woefully-misnamed espresso medicinal from the hegemon's coffee kiösk there, then drove downtown and parked near the library construction site; I had some time to kill before I was scheduled to rendezvous at University and Shattuck at 1745 with a local genetics blogger with whom I had arranged to give a ride to the party. I walked to Ming Quong and bought a "FEMINISM IS THE RADICAL NOTION THAT WOMEN ARE PEOPLE" button to put on my bag as a replacement for the one I had bought in 'aught-six and lost at some point. I had recently reöutfitted my bag with buttons I had bought from a site I found because the proprietor occasionally commented on the blog (_the_ blog). My newly-accessorized bag could hardly be complete without a gender pin, and for some sentimental reason I wanted it _before_ taking the geneticist to the social. I have a weakness for what you might call _narrative optimization_: doing things not for any real-world utility, but rather because they would seem thematically appropriate if this were a story rather than real life.

+I worked the 0600 to 1500 bookkeeper/customer-service shift at my supermarket dayjob that day. After work, I dropped off the week's bag of redeemed manufacturer's coupons at store #936 (what the company did with them after that, I was never told—perhaps they weighed them), bought a woefully-misnamed espresso medicinal from the hegemon's coffee kiösk there, then drove downtown and parked near the library construction site; I had some time to kill before I was scheduled to rendezvous at University and Shattuck at 1745 with a local genetics blogger with whom I had arranged to give a ride to the party. I walked to Ming Quong and bought a "FEMINISM IS THE RADICAL NOTION THAT WOMEN ARE PEOPLE" button to put on my bag as a replacement for the one I had bought in 'aught-six and lost at some point. I had recently reöutfitted my bag with buttons I had bought from a site I found because the proprietor occasionally commented on the blog (_the_ blog). My newly-accessorized bag could hardly be complete without a gender pin, and for some sentimental reason I wanted it _before_ taking the geneticist to the social. <a id="narrative-optimization"></a>I have a weakness for what you might call _narrative optimization_: doing things not for any real-world utility, but rather because they would seem thematically appropriate if this were a story rather than real life.

(I still have the "radical notion" pin, but it's no longer proudly pinned to my backpack. Ideology—in the general case—is not my style anymore.)

The young James Boylan had a question. What's it _like_, how does it _feel_. The question deserves an answer.

-I bought my first pair of breastforms in January 2008 (I was 20 years old). I think those mysteriously disappeared around that one time my mother unilaterally cleaned out my closet, but I bought another pair (a very high-quality model, plus accessories, for $240 that I probably couldn't afford at the time, but this was _important_) in July 2010. And I would wear them in private from time to time, and that was nice, but they were still, noticeably ... not actually part of my body. Not an answer to the question.

+<a id="first-breastforms"></a>I bought my first pair of breastforms in January 2008 (I was 20 years old). I think those mysteriously disappeared around that one time my mother unilaterally cleaned out my closet, but I bought another pair (a very high-quality model, plus accessories, for $240 that I probably couldn't afford at the time, but this was _important_) in July 2010. And I would wear them in private from time to time, and that was nice, but they were still, noticeably ... not actually part of my body. Not an answer to the question.

And later, on one of the few occasions when I was alone in bed with a woman, I complemented her on her breasts, and mused out loud that, though I had some amount of breast tissue, my chest wasn't interesting like hers.

I don't want to live in that world.

-So here is my policy, I, Taylor Saotome-Westlake, at least on this blog, at least under this name—

+So here is my policy, at least on this blog—

If I say something that is later shown to me to be _factually incorrect_, that's something I take _very_ seriously, and I will do everything in my power to make it right.

This works because, empirically, mammals have lots of things in common with each other and water-dwellers have lots of things in common with each other. If we [imagine entities as existing in a high-dimensional configuration space](http://lesswrong.com/lw/nl/the_cluster_structure_of_thingspace/), there would be a _mammals_ cluster (in the subspace of the dimensions that mammals are similar on), and a _water-dwellers_ cluster (in the subspace of the dimensions that water-dwellers are similar on), and whales would happen to belong to _both_ of them, in the way that the vector *x⃗* = [3.1, 4.2, −10.3, −9.1] ∈ ℝ⁴ is close to [3, 4, 2, 3] in the _x₁-x₂_ plane, but also close to [−8, −9, −10, −9] in the _x₃-x₄_ plane.

-If different political factions are engaged in conflict over how to define the extension of some common word—common words being a scarce and valuable resource both culturally and [information-theoretically](http://lesswrong.com/lw/o1/entropy_and_short_codes/)—rationalists may not be able to say that one side is simply right and the other is simply wrong, but we can at least strive for objectivity in _describing the conflict_. Before shrugging and saying, "Well, this is a difference in values; nothing more to be said about it," we can talk about the detailed consequences of what is gained or lost by paying attention to some differences and ignoring others. That there exists an element of subjectivity in what you choose to pay attention to, doesn't negate the fact that there _is_ a structured empirical reality to be described—and not all descriptions of it are equally compact.

+<a id="describing-the-conflict"></a>If different political factions are engaged in conflict over how to define the extension of some common word—common words being a scarce and valuable resource both culturally and [information-theoretically](http://lesswrong.com/lw/o1/entropy_and_short_codes/)—rationalists may not be able to say that one side is simply right and the other is simply wrong, but we can at least strive for objectivity in _describing the conflict_. Before shrugging and saying, "Well, this is a difference in values; nothing more to be said about it," we can talk about the detailed consequences of what is gained or lost by paying attention to some differences and ignoring others. That there exists an element of subjectivity in what you choose to pay attention to, doesn't negate the fact that there _is_ a structured empirical reality to be described—and not all descriptions of it are equally compact.

In terms of the Lincoln riddle: you _can_ call a tail a leg, but you can't stop people from _noticing_ that out of a dog's five legs, one of them is different from the others. You can't stop people from inferring decision-relevant implications from what they notice. (_Most_ of a dog's legs touch the ground, such that you'd have to carry the dog to the vet if one of them got injured, but the dog can still walk without the other, different leg.) And if people who live and work with dogs every day find themselves habitually distinguishing between the bottom-walking-legs and the back-wagging-leg, they _just might_ want _different words_ in order to concisely _talk_ about what everyone is thinking _anyway_.

I _am_, however, supposing that the late-onset type or types is either not an intersex condition, or at _most_, a very mild one: we could perhaps imagine a gender identity "switch" in the brain that can get flipped around (explaining the eventual need to transition) without much affecting other sexually-dimorphic parts of the brain (explaining how transition could be delayed so long, and come as such a surprise to others). This hypothesis is weaker than the autogynephilia theory, but still has implications for the ways in which transgender identity claims might or might not be validated by natural, prediction-motivated categorization schemes. If most trans women's traits are noticeably _not drawn from from the female distribution_, that's a factor making it less practical to insist that others categorize them as women.

-<a id="anchor-different-types-of-women-objection"></a>To this it might be objected that there are many different types of women. Clusters can internally have many subclusters: Pureto Rican women (or married women, or young women, or lesbians, _&c_.) don't have the _same_ distribution of traits as women as a whole, and yet are still women. Why should "trans" be different from any other adjective one might use to specify a subcategory of women?

+<a id="different-types-of-women-objection"></a>To this it might be objected that there are many different types of women. Clusters can internally have many subclusters: Pureto Rican women (or married women, or young women, or lesbians, _&c_.) don't have the _same_ distribution of traits as women as a whole, and yet are still women. Why should "trans" be different from any other adjective one might use to specify a subcategory of women?

What makes this difficult is that—_conditional_ on the two-types hypothesis and specifically gender dysphoria in non-exclusively-androphilic biological males being mostly not an intersex condition—most trans women aren't just not part of the female cluster in configuration space; they're specifically part of _male_ cluster along most dimensions, which people _already_ have a concept for. This doesn't mean that we can't get away with classifying them as women—there's nothing _stopping_ us from drawing the category boundary however we want. But it [isn't an arbitrary choice](/2018/Feb/blegg-mode/)—the concepts of _women_-as-defined-by-biological-sex, _women_-as-defined-by-self-identity, and _women_-as-defined-by-passing are picking out different (though of course mostly overlapping) regions of the configuration space, which has inescapable logical [consequences](http://lesswrong.com/lw/nx/categorizing_has_consequences/) on the kinds of inferences that can be made using each concept.

People should get what they want. Social science is hard and I want to _try_ to avoid politics as much as I can.[ref]Unfortunately, a very challenging goal in the gender blogging business.[/ref] When different people's wants come into conflict, it's not for me to say what the optimal compromise is; it's too much for me to compute.

-<a id="anchor-pronoun-sticker-discourse"></a>What I can say is that _whatever_ the right thing to do is, we stand a better chance of getting there if we can be _honest_ with each other about the world we see, using the most precise categories we can, to construct maps that reflect the territory. My model of the universe doesn't stop at the boundary of your body, and yours shouldn't stop at mine.

+<a id="pronoun-sticker-discourse"></a>What I can say is that _whatever_ the right thing to do is, we stand a better chance of getting there if we can be _honest_ with each other about the world we see, using the most precise categories we can, to construct maps that reflect the territory. My model of the universe doesn't stop at the boundary of your body, and yours shouldn't stop at mine.

This is definitely compatible with transitioning. It is _not_, I claim, compatible with the ideology of gender-as-self-identification that is rapidly establishing a foothold in Society. Consider this display at a recent conference of the American Philosophical Association (note, the people whose _job_ it is to use careful conceptual distinctions to understand reality)—

-----

-Alexander ends his post by citing, as "one of the most heartwarming episodes in the history of one of my favorite places in the world," the case of 19th century San Francisco resident [Joshua Norton](https://en.wikipedia.org/wiki/Emperor_Norton), who proclaimed himself Emperor Norton I of the United States and Protector of Mexico and whose claims to power were widely humored by local citizens. Restaurants accepted currency issued in his name; the city's Board of Supervisors bought him a uniform.

+<a id="emperor-norton"></a>Alexander ends his post by citing, as "one of the most heartwarming episodes in the history of one of my favorite places in the world," the case of 19th century San Francisco resident [Joshua Norton](https://en.wikipedia.org/wiki/Emperor_Norton), who proclaimed himself Emperor Norton I of the United States and Protector of Mexico and whose claims to power were widely humored by local citizens. Restaurants accepted currency issued in his name; the city's Board of Supervisors bought him a uniform.

Norton's story is certainly _entertaining to read about_ a hundred and forty years after the fact. But before endorsing it as a model of humane behavior, I think it's worth dwelling on what it would be like to live through, not just read about as a historical curiosity.

<a id="post-ideas-list"></a>

- * I still need to finish drafting my reply to [Ozy's reply](https://thingofthings.wordpress.com/2018/06/18/man-should-allocate-some-more-categories/) to [my reply](http://unremediatedgender.space/2018/Feb/the-categories-were-made-for-man-to-make-predictions/) to [the immortal Scott Alexander](http://web.archive.org/web/20200610230130/https://slatestarcodex.com/2014/11/21/the-categories-were-made-for-man-not-man-for-the-categories/)

+ * <a id="reply-to-ozy"></a>I still need to finish drafting my reply to [Ozy's reply](https://thingofthings.wordpress.com/2018/06/18/man-should-allocate-some-more-categories/) to [my reply](http://unremediatedgender.space/2018/Feb/the-categories-were-made-for-man-to-make-predictions/) to [the immortal Scott Alexander](http://web.archive.org/web/20200610230130/https://slatestarcodex.com/2014/11/21/the-categories-were-made-for-man-not-man-for-the-categories/)

* I've got ~4800 words drafted, but it needs a _lot_ more work in order to make it a maximally clear and maximally defensible blog post

* A _brief_ (only ~350 words) summary—

* I hopefully-accurately summarize Ozy as trying to make a _reductio ad absurdum_ argument, claiming that my arguments relying on the relevance of psychological sex differences would imply that lesbians aren't women, which is absurd.

And somehow it _doesn't land_. It's like talking to a tape recorder that just endlessly repeats, "Ha-ha! [I can define a word any way I want](http://lesswrong.com/lw/od/37_ways_that_words_can_be_wrong/)! You can't use that concept unless you can provide explicit necessary-and-sufficient conditions to classify a series of ever-more obscure and contrived edge cases!"

-Although I do have a couple favorite edge cases of my own. I generally prefer not to involve named individuals in arguments, even public figures: it's unclassy. But having nothing left, I pull out a [photograph of Danielle Muscato](http://daniellemuscato.startlogic.com/uploads/3/4/9/3/34938114/2249042_orig.jpg). "Look," I say. "This is a photograph of a man. You can see it, too, right? Right?"

+<a id="photo-of-danielle-muscato"></a>Although I do have a couple favorite edge cases of my own. I generally prefer not to involve named individuals in arguments, even public figures: it's unclassy. But having nothing left, I pull out a [photograph of Danielle Muscato](http://daniellemuscato.startlogic.com/uploads/3/4/9/3/34938114/2249042_orig.jpg). "Look," I say. "This is a photograph of a man. You can see it, too, right? Right?"

And they say, "It's possible to be mistaken about cis people's genders, too."

Maybe with more time and more effort I could find _exactly_ the right words to cover every possible caveat and nitpick and _finally_ be able to communicate the thing—

-But maybe I just need to relax. Not take it so seriously. Forget about the topic for a few days or a few months. Wash the goddamned dishes, write some goddamned code. _Maybe_ it's not [the end of the world](http://unremediatedgender.space/2017/Jan/from-what-ive-tasted-of-desire/) if someone is Wrong on the Internet.

+But maybe I just need to relax. Not take it so seriously. Forget about the topic for a few days or a few months. Wash the goddamned dishes, write some goddamned code. _Maybe_ it's not [the end of the world](/2017/Jan/from-what-ive-tasted-of-desire/) if someone is Wrong on the Internet.

I think another part of it is an intuition about—how do I put this? Not wanting to commit fraud?—or not wanting to commit _obvious_ fraud. The reason I'm so glad that [there's a word for the thing](/2017/Feb/a-beacon-through-the-darkness-or-getting-it-right-the-first-time/) that isn't "crossdresser" or "transvestite" is because it's not about the clothes; it's about wanting to actually have the body of the other sex. The clothes are just a prop. And the prop ... _noticeably doesn't work_. I don't pass; I have _never_ passed. My voice is wrong; my skeleton is wrong; my movement is wrong; my face continues to be wrong despite makeup. At least at Fanime (where everyone _and her dog_ is in costume) there's no pretense that the pretense is anything more than that. If you fool someone—if only for a moment—then great, but if not, then at least you're not fooling anyone about whether you're fooling yourself.

-I'm probably just _bad_ at crossdressing/cosplay? I've never put the kind of _effort_ into, say, a makeup tutorial the way I do for my intellectual endeavors. My Fanime costume was authored by the Amazon product recommendation algorithm: after adding the pink wig to my shopping cart, [the "Discover Related Products" sidebar picked out](/images/discover_related_products.png) the hoop skirt and the Mr. Universe tee from Episode 48 ["Story for Steven"](https://steven-universe.fandom.com/wiki/Story_for_Steven). (The sword in the photo illustrating this post is borrowed from another cosplayer cropped out-of-frame.) And unless I become more skilled, I feel like I've hit diminishing returns on conventions—like whatever I was going to get out the experience, I would have gotten either this time or one of the last six (previously: [as Ens. Silvia Tilly at San Francisco Comic-Con 2018](/images/tilly_cosplay.png), as _Equestria Girls_ Twilight Sparkle at BABSCon 2018, [as Korra at San Francisco Comic-Con 2017](/2017/Oct/a-leaf-in-the-crosswind/), [as Pearl at FanimeCon 2017](http://zackmdavis.net/blog/2017/05/gems-will-be-gems/), as [Lt. Jadzia Dax (circa 2369) at the _Star Trek_ 50 Year Mission Tour San Francisco 2016](/2016/Dec/joined/), [as Pearl as San Francsico Comic-Con 2016](/2016/Sep/is-there-affirmative-action-for-incompetent-crossplay/)).

+I'm probably just _bad_ at crossdressing/cosplay? I've never put the kind of _effort_ into, say, a makeup tutorial the way I do for my intellectual endeavors. My Fanime costume was authored by the Amazon product recommendation algorithm: after adding the pink wig to my shopping cart, [the "Discover Related Products" sidebar picked out](/images/discover_related_products.png) the hoop skirt and the Mr. Universe tee from Episode 48 ["Story for Steven"](https://steven-universe.fandom.com/wiki/Story_for_Steven). (The sword in the photo illustrating this post is borrowed from another cosplayer cropped out-of-frame.) And unless I become more skilled, I feel like I've hit diminishing returns on conventions—like whatever I was going to get out the experience, I would have gotten either this time or one of the last six (previously: [as Ens. Sylvia Tilly at San Francisco Comic-Con 2018](/images/tilly_cosplay.png), as _Equestria Girls_ Twilight Sparkle at BABSCon 2018, [as Korra at San Francisco Comic-Con 2017](/2017/Oct/a-leaf-in-the-crosswind/), [as Pearl at FanimeCon 2017](http://zackmdavis.net/blog/2017/05/gems-will-be-gems/), as [Lt. Jadzia Dax (circa 2369) at the _Star Trek_ 50 Year Mission Tour San Francisco 2016](/2016/Dec/joined/), [as Pearl as San Francisco Comic-Con 2016](/2016/Sep/is-there-affirmative-action-for-incompetent-crossplay/)).

<a id="tech-conference"></a>As far as other special events go, I'm flying out to Portland—the real Portland—tonight for a tech conference, and to visit friend of the blog [Sophia](/author/sophia/). You'd think a few days of vacation should do me good—I've been an psychological wreck all year (I mean, even more than my average year) over having accidentally catalyzed a civil war in my local robot cult—except that the same cultural forces that have subtly-yet-fatally corrupted my beautiful robot cult, just _own_ the open-source tech scene outright, which is likely to present a source of additional stress. The spirit of bravery that sings, [_I will fight for the place where I'm free—for the world I was made in_](https://genius.com/16627280), must subsist in a brain wracked by constant emotional pain that—sometimes—is just tired of fighting.

<a id="ace-model"></a>The third part of the book is about genetic influences on class structure! Untangling the true causes of human variation is a really hard technical philosophy problem, but behavioral geneticists have at least gotten started with their simple _ACE_ model. It works like this: first, assume (that is, "pretend") that the genetic variation for a trait is _additive_ (if you have the appropriate SNP, you get more of the trait), rather than exhibiting _epistasis_ (where the effects of different loci interfere with each other) or Mendelian _dominance_ (where the presence of just one copy of an allele (of two) determines the phenotype, and it doesn't matter whether you heterozygously have a different allele as your second version of that gene). Then we pretend that we can partition the variance in phenotypes as the sum of the "additive" genetic variance _A_, plus the environmental variance "common" within a family _C_, plus "everything else" (including measurement "error" and the not-shared-within-families "environment") _E_. Briefly (albeit at the risk of being _cliché_): nature, nurture, and _noise_.

-Then we can estimate the sizes of the _A_, _C_, and _E_ components by studying fraternal and identical twins. (If you hear people talking about "twin studies", this is what they mean—_not_ case studies of identical twins raised apart, which _are_ really cool but don't happen very often.) Both kinds of twins have the same family environment _C_ at the same time (parents, socioeconomic status, schools, _&c._), but identical twins are twice as genetically related to each other as fraternal twins, so the extent to which the identical twins are more similar is going to pretty much be because of their genes. "Pretty much" in the sense that while there are ways in which the assumptions of the model aren't quite true (assortative mating makes fraternal twins more similar in the ways their parents were _already_ similar before mating, identical twins might get treated more similarly by "the environment" on account of their appearance), Murray assures us that the experts assure us that the _quantitative_ effect of these deviations are probably pretty small!

+<a id="twin-studies"></a>Then we can estimate the sizes of the _A_, _C_, and _E_ components by studying fraternal and identical twins. (If you hear people talking about "twin studies", this is what they mean—_not_ case studies of identical twins raised apart, which _are_ really cool but don't happen very often.) Both kinds of twins have the same family environment _C_ at the same time (parents, socioeconomic status, schools, _&c._), but identical twins are twice as genetically related to each other as fraternal twins, so the extent to which the identical twins are more similar is going to pretty much be because of their genes. "Pretty much" in the sense that while there are ways in which the assumptions of the model aren't quite true (assortative mating makes fraternal twins more similar in the ways their parents were _already_ similar before mating, identical twins might get treated more similarly by "the environment" on account of their appearance), Murray assures us that the experts assure us that the _quantitative_ effect of these deviations are probably pretty small!

Anyway, it turns out that the effect of the shared environment _C_ for most outcomes is smaller than most people intuitively expect—actually close to zero for personality and adult intelligence specifically! Sometimes sloppy popularizers summarize this as "parenting doesn't matter" in full generality, but it depends on the trait or outcome you're measuring: for example, the shared environment component gets up to 25% for years-of-schooling ("educational attainment") and 36% for "basic interpersonal interactions." _Culture_ obviously exists, but for underlying psychological traits, the part of the environment that matters is mostly not shared by siblings in the same family—not the part of the environment we know how to control. Thus, a lot of economic and class stratification actually ends up being along genetic lines: the nepotism of family wealth can buy opportunities and second chances, but it doesn't actually live your life for you.

Anyway, so Murray and Herrnstein talk about this "intelligence" construct, and how it's heritable, and how it predicts income, school success, not being a criminal, _&c._, and how Society is becoming increasingly stratified by cognitive abilities, as school credentials become the ticket to the new upper class.

-This _should_ just be more social-science nerd stuff, the sort of thing that would only draw your attention if, like me, you feel bad about not being smart enough to do algebraic topology and want to console yourself by at least knowing about the Science of not being smart enough to do algebraic topology. The reason everyone _and her dog_ is still mad at Charles Murray a quarter of a century later is Chapter 13, "Ethnic Differences in Cognitive Ability", and Chapter 14, "Ethnic Inequalities in Relation to IQ". So, _apparently_, different ethnic/"racial" groups have different average scores on IQ tests. [Ashkenazi Jews do the best](http://web.archive.org/web/20200620184942/https://slatestarcodex.com/2017/05/26/the-atomic-bomb-considered-as-hungarian-high-school-science-fair-project/), which is why I sometimes privately joke that the fact that I'm [only 85% Ashkenazi (according to 23andMe)](/images/ancestry_report.png) explains my low IQ. ([I got a 131](/images/wisc-iii_result.jpg) on the [WISC-III](https://en.wikipedia.org/wiki/Wechsler_Intelligence_Scale_for_Children) at age 10, but that's pretty dumb [compared to](http://zackmdavis.net/blog/2016/06/the-view-from-below/) some of my [robot-cult](/tag/my-robot-cult/) friends.) East Asians do a little better than Europeans/"whites". And—this is the part that no one is happy about—the difference between U.S. whites and U.S. blacks is about Cohen's _d_ ≈ 1. (If two groups differ by _d_ = 1 on some measurement that's normally distributed within each group, that means that the mean of the group with the lower average measurement is at the 16th percentile of the group with the higher average measurement, or that a uniformly-randomly selected member of the group with the higher average measurement has a probability of about 0.76 of having a higher measurement than a uniformly-randomly selected member of the group with the lower average measurement.)

+<a id="the-reason-everyone-and-her-dog-is-still-mad"></a>This _should_ just be more social-science nerd stuff, the sort of thing that would only draw your attention if, like me, you feel bad about not being smart enough to do algebraic topology and want to console yourself by at least knowing about the Science of not being smart enough to do algebraic topology. The reason everyone _and her dog_ is still mad at Charles Murray a quarter of a century later is Chapter 13, "Ethnic Differences in Cognitive Ability", and Chapter 14, "Ethnic Inequalities in Relation to IQ". So, _apparently_, different ethnic/"racial" groups have different average scores on IQ tests. [Ashkenazi Jews do the best](http://web.archive.org/web/20200620184942/https://slatestarcodex.com/2017/05/26/the-atomic-bomb-considered-as-hungarian-high-school-science-fair-project/), which is why I sometimes privately joke that the fact that I'm [only 85% Ashkenazi (according to 23andMe)](/images/ancestry_report.png) explains my low IQ. ([I got a 131](/images/wisc-iii_result.jpg) on the [WISC-III](https://en.wikipedia.org/wiki/Wechsler_Intelligence_Scale_for_Children) at age 10, but that's pretty dumb [compared to](http://zackmdavis.net/blog/2016/06/the-view-from-below/) some of my [robot-cult](/tag/my-robot-cult/) friends.) East Asians do a little better than Europeans/"whites". And—this is the part that no one is happy about—the difference between U.S. whites and U.S. blacks is about Cohen's _d_ ≈ 1. (If two groups differ by _d_ = 1 on some measurement that's normally distributed within each group, that means that the mean of the group with the lower average measurement is at the 16th percentile of the group with the higher average measurement, or that a uniformly-randomly selected member of the group with the higher average measurement has a probability of about 0.76 of having a higher measurement than a uniformly-randomly selected member of the group with the lower average measurement.)

Given the tendency for people to distort shared maps for political reasons, you can see why this is a hotly contentious line of research. Even if you take the test numbers at face value, racists trying to secure unjust privileges for groups that score well, have an incentive to "play up" group IQ differences in bad faith even when they shouldn't be [relevant](https://www.lesswrong.com/posts/GSz8SrKFfW7fJK2wN/relevance-norms-or-gricean-implicature-queers-the-decoupling). As economist Glenn C. Loury points out in _The Anatomy of Racial Inequality_, cognitive abilities decline with _age_, and yet we don't see a moral panic about the consequences of an aging workforce, because older people are construed by the white majority as an "us"—our mothers and fathers—rather than an outgroup. _Individual_ differences in intelligence are also presumably less politically threatening because "smart people" as a group aren't construed as a natural political coalition—although Murray's work on cognitive class stratification would seem to suggest this intuition is mistaken.

It probably wouldn't have mattered either way, with so many messages flying by in the chat. In some ways, Blue Egregore is less like an ideology and more like a regular expression filter: you can get surprisingly far into discussing the actual substance of ideas as long as no one _says a bad word_ like "eugenics".

-—if we even have enough _time_ for things like embryo selection to help, if AI research somehow keeps plodding along [even as everything _else_ falls apart](https://www.unqualified-reservations.org/2007/05/antisingularity/). The [GPT-3 demos](https://www.gwern.net/GPT-3) have been tickling my neuroticism. Sure, it's "just" a language model, doing nothing more but predicting the next token of human-generated text. But [you can do a lot with language](https://bmk.sh/2020/08/17/Building-AGI-Using-Language-Models/). As _disgusted_ as I am with my robot cult as presently constituted, the _argument_ for why you should fear the coming robot apocalypse in which all will be consumed in a cloud of tiny molecular paperclips, still looks solid. But I had always thought of it as a long-term thing—this unspoken sense of, okay, we're probably all going to die, but that'll probably be in, like, 2060 or whatever. People freaking out about it coming _soon_-soon are probably just [following the gradient into](https://www.lesswrong.com/posts/yEjaj7PWacno5EvWa/every-cause-wants-to-be-a-cult) being [a doomsday cult](https://unstableontology.com/2019/07/11/the-ai-timelines-scam/). Now the threat, [and the uncertainty around it](https://intelligence.org/2017/10/13/fire-alarm/), feel more real—like maybe we'll all die in 2035 instead of 2060.

+<a id="if-we-even-have-enough-time"></a>—if we even have enough _time_ for things like embryo selection to help, if AI research somehow keeps plodding along [even as everything _else_ falls apart](https://www.unqualified-reservations.org/2007/05/antisingularity/). The [GPT-3 demos](https://www.gwern.net/GPT-3) have been tickling my neuroticism. Sure, it's "just" a language model, doing nothing more but predicting the next token of human-generated text. But [you can do a lot with language](https://bmk.sh/2020/08/17/Building-AGI-Using-Language-Models/). As _disgusted_ as I am with my robot cult as presently constituted, the _argument_ for why you should fear the coming robot apocalypse in which all will be consumed in a cloud of tiny molecular paperclips, still looks solid. But I had always thought of it as a long-term thing—this unspoken sense of, okay, we're probably all going to die, but that'll probably be in, like, 2060 or whatever. People freaking out about it coming _soon_-soon are probably just [following the gradient into](https://www.lesswrong.com/posts/yEjaj7PWacno5EvWa/every-cause-wants-to-be-a-cult) being [a doomsday cult](https://unstableontology.com/2019/07/11/the-ai-timelines-scam/). Now the threat, [and the uncertainty around it](https://intelligence.org/2017/10/13/fire-alarm/), feel more real—like maybe we'll all die in 2035 instead of 2060.

At some point, I should write a post on the causes and consequences of the psychological traits of fictional characters not matching the real-life distributions by demographic. [The new _Star Trek_ cartoon](https://memory-alpha.fandom.com/wiki/Star_Trek:_Lower_Decks) is not very good, but I'm obligated to enjoy it anyway out of brand loyalty. One of the main characters, Ens. Beckett Mariner, is [brash and boisterous and dominant](https://youtu.be/64obsPsXxkE?t=45)—[friendly, but in a way](https://www.youtube.com/watch?v=7CVJGy0Do5I) that makes it clear that she's _on top_. If you've seen _Rick and Morty_, her relationship with Ens. Brad Boimler has the Rick and Morty dynamic, with Mariner as Rick. ([Series creator](https://en.wikipedia.org/wiki/Mike_McMahan) Mike McMahan actually worked on _Rick and Morty_, so it likely _is_ the same dynamic, not just superficially, but generated by the same algorithm in McMahan's head.)

Title: Link: "Blood Is Thicker Than Water 🐬"

Date: 2021-09-30 09:35

Category: other

-Tags: categorization, epistemology, linkpost

+Tags: categorization, epistemology, linkpost, whale metaphors

Ha ha, [those _Less Wrong_ guys sure love dolphins for whatever reason!](https://www.lesswrong.com/posts/vhp2sW6iBhNJwqcwP/blood-is-thicker-than-water) [(Alternative viewer.)](https://www.greaterwrong.com/posts/vhp2sW6iBhNJwqcwP/blood-is-thicker-than-water) Note that the "root of the causal graph" argument here for the relevance of phylogenetics is equivalent to [the case that sex chromosomes are a good way to operationalize _sex_ in humans](/2021/May/sexual-dimorphism-in-the-sequences-in-relation-to-my-gender-problems/#chromosomes)—it's not that anyone directly sees chromosomes on a day-to-day basis; it's that chromosomes are the "switch" upstream of the development of all other sex differences. Talking about the setting of the switch (which you don't _intrinsically_ care about) is a concise way to sum over the many, many high-dimensional details that you do care about.

From the standpoint of my secret erotic fantasy, "normal, masculine man wearing a female body like a suit of clothing" is actually a _great_ outcome—the _ideal_ outcome. Let me explain.

-The main plot of my secret erotic fantasy accommodates many frame stories, but I tend to prefer those that invoke the [literary genre of science](https://www.lesswrong.com/posts/4Bwr6s9dofvqPWakn/science-as-attire), and posit "technology" rather than "spells" or "potions" as the agent of transformation, even if it's all ultimately magic (where ["magic" is a term of art for anything you don't understand how to implement as a computer program](https://www.lesswrong.com/posts/kpRSCH7ALLcb6ucWM/say-not-complexity)).

+<a id="secret-fantasy-frame-stories"></a>The main plot of my secret erotic fantasy accommodates many frame stories, but I tend to prefer those that invoke the [literary genre of science](https://www.lesswrong.com/posts/4Bwr6s9dofvqPWakn/science-as-attire), and posit "technology" rather than "spells" or "potions" as the agent of transformation, even if it's all ultimately magic (where ["magic" is a term of art for anything you don't understand how to implement as a computer program](https://www.lesswrong.com/posts/kpRSCH7ALLcb6ucWM/say-not-complexity)).

So imagine having something like [the transporter in _Star Trek_](https://memory-alpha.fandom.com/wiki/Transporter), but you re-materialize with the body of someone else, rather than your original body—a little booth I could walk in, dissolve in a tingly glowy special effect for a few seconds, and walk out looking like (say) [Nana Visitor (circa 1998)](https://memory-alpha.fandom.com/wiki/Kay_Eaton?file=Kay_Eaton.jpg). (In the folklore of [female-transformation erotica](/2016/Oct/exactly-what-it-says-on-the-tin/), this machine is often called the ["morphic adaptation unit"](https://www.cyoc.net/interactives/chapter_115321.html).)

From context, it seems like the idea was targeted at men who disdain women as a mysterious Other—but the same moral applies to men who are in ideologically-motivated denial about how male-typical they are, and whether this has implications. [At the time, I certainly didn't want to think of myself _as a man_.](https://www.greaterwrong.com/posts/FBgozHEv7J72NCEPB/my-way#comment-7ZwECTPFTLBpytj7b) And yet ...

-For example. When I read things from the [systematizing–empathizing](https://en.wikipedia.org/wiki/Empathising%E2%80%93systemising_theory)/"men are interested in things, women are interested in people" line of research—which, to be clear that you know that I know, is [only a mere statistical difference at a mere Cohen's _d_ ≈ 0.93](http://unremediatedgender.space/papers/su_et_al-men_and_things_women_and_people.pdf), not an absolute like genitals or chromosomes—my instinctive reaction is, "But, but, that's not _fair_. People _are_ systems, because _everything_ is a system. [What kind of a lame power is empathy, anyway?](https://tvtropes.org/pmwiki/pmwiki.php/Main/WhatKindOfLamePowerIsHeartAnyway)"

+For example. When I read things from the [systematizing–empathizing](https://en.wikipedia.org/wiki/Empathising%E2%80%93systemising_theory)/"men are interested in things, women are interested in people" line of research—which, to be clear that you know that I know, is [only a mere statistical difference at a mere Cohen's _d_ ≈ 0.93](/papers/su_et_al-men_and_things_women_and_people.pdf), not an absolute like genitals or chromosomes—my instinctive reaction is, "But, but, that's not _fair_. People _are_ systems, because _everything_ is a system. [What kind of a lame power is empathy, anyway?](https://tvtropes.org/pmwiki/pmwiki.php/Main/WhatKindOfLamePowerIsHeartAnyway)"

[But the map is not the territory](https://www.lesswrong.com/posts/np3tP49caG4uFLRbS/the-quotation-is-not-the-referent). We don't have unmediated access to reality beyond [the Veil of Maya](https://web.archive.org/web/20020606121040/http://singinst.org/GISAI/mind/consensus.html); system-ness in the empathizing/systematizing sense is a feature of our _models_ of the world, not the world itself.

(I guess I can't evade responsibility for the fact that I am, in fact, blogging about this.)

-A clue: when I'm masturbating, and imagining all the forms I would take if the magical transformation technology were real (the frame story can vary, but the basic idea is always the same), I don't think I'm very _good_ at first-person visualization? The _content_ of the fantasy is about _me_ being a woman (I mean, having a woman's body), but the associated mental imagery mostly isn't the first-person perspective I would actually experience if the fantasy were real; I think I'm mostly imagining a specific woman (which one, varies a lot) as from the outside, admiring her face, and her voice, and her breasts, but somehow wanting the soul behind those eyes to be _me_. Wanting _my_ body to be shaped like _that_, to be in control of that avatar of beauty—not even to _do_ anything overtly "sexy" in particular, but just to exist like that.

+A clue: when I'm masturbating, and imagining all the forms I would take if the magical transformation technology were real (the frame story can vary, but the basic idea is always the same), I don't think I'm very _good_ at first-person visualization? The _content_ of the fantasy is about _me_ being a woman (I mean, having a woman's body), but the associated mental imagery mostly isn't the first-person perspective I would actually experience if the fantasy were real; I think I'm mostly imagining a specific woman (which one, varies a lot) as from the outside, admiring her face, and her voice, and her breasts, but somehow wanting the soul behind those eyes to be _me_. Wanting _my_ body to be shaped like _that_, to be in control of that avatar of beauty—not even necessarily to _do_ anything overtly "sexy" in particular, but just to exist like that.

If the magical transformation technology were real, I would want a full-length mirror. (And in the real world, I would probably crossdress a _lot_ more often, if I could pass to myself in the mirror. My face ruins it and makeup doesn't help.)

My [laser beard removal sessions](/tag/lasers/) were ... arguably a waste of money, since I still have to shave even after 13 treatments?—but it at least got the density of my ugly–gross facial hair down a bit. Trying it was definitely a _smart move_ given what I knew at the time, and I _just might_ be rich enough and disgusted-by-facial-hair enough to go back for more density-reduction. (Electrolysis gets better results than laser, but it's more expensive and a lot more painful.)

-People get cosmetic surgery sometimes for non-sex-change-related reasons. I guess if I grew a little braver and a little more desperate, I could imagine wanting to research if and how "mild" facial feminization surgery is a thing—just, selfishly, to be happier with my reflection. (Probably a _smarter move_ to check out [movie-grade latex masks](https://www.creafx.com/en/special-make-up-effects/taylor-silicone-mask/) first, to see if it's at all possible to attain the bliss of passing in the mirror _without_ taking a knife to my one and only real-life face.)

+<a id="movie-grade-mask"></a>People get cosmetic surgery sometimes for non-sex-change-related reasons. I guess if I grew a little braver and a little more desperate, I could imagine wanting to research if and how "mild" facial feminization surgery is a thing—just, selfishly, to be happier with my reflection. (Probably a _smarter move_ to check out [movie-grade latex masks](https://www.creafx.com/en/special-make-up-effects/taylor-silicone-mask/) first, to see if it's at all possible to attain the bliss of passing in the mirror _without_ taking a knife to my one and only real-life face.)

And I should probably look into [figuring out if there's anything to be done](https://en.wikipedia.org/wiki/Pattern_hair_loss#Treatment) for my hairline before it gets any worse?

The author probably doesn't believe in the typology (if she's even heard of it), but _the traits line up anyway_. Carrie is straight—gynephilic (["Guys just aren't my thing"](http://www.dolari.org/cs/16.htm), she tells her sister). Carrie's gay (androphilic) drag queen friend Victor/Victoria [doesn't understand Carrie's motivations](http://www.dolari.org/cs/67.htm): "Not to mention you don't _think_ like one of 'them'", she comments on Carrie's lack of innate femininity. (Anyone can see that effeminate gay men taking on female roles "make sense"; autogynephilia is harder to understand if you haven't yourself felt the tug of the scintillating but ultimately untrue thought.) Allison's recollection of her origins includes a moment of envy about a girl: ["she looks so pretty ... so pretty"](http://www.dolari.org/cs/342.htm). Heidi the (male) dominatrix [displays a working knowledge of the typology while coming on to Carrie](http://www.dolari.org/cs/268.htm): "We're both crossdressers, and we aren't anything like drag queens [...] sometimes I want to hang out with someone like me. Someone like you." Indeed!

-Likewise, Carrie's [beautiful pure sacred self-identity feelings](/2021/May/sexual-dimorphism-in-the-sequences-in-relation-to-my-gender-problems/#beautiful-pure-sacred-self-identity) (["And I feel a longing ... like I'd have a body like that once upon a time, and want it back"](http://www.dolari.org/cs/231.htm)) and [stirring post-transition](http://www.dolari.org/cs/239.htm) [meta-attraction](https://surveyanon.wordpress.com/2019/09/10/meta-attraction-cannot-account-for-all-autogynephiles-interest-in-men/) are _on type_.

+Likewise, Carrie's [beautiful pure sacred self-identity feelings](/2021/May/sexual-dimorphism-in-the-sequences-in-relation-to-my-gender-problems/#beautiful-pure-sacred-self-identity) (["And I feel a longing ... like I'd had a body like that once upon a time, and want it back"](http://www.dolari.org/cs/231.htm)) and [stirring post-transition](http://www.dolari.org/cs/239.htm) [meta-attraction](https://surveyanon.wordpress.com/2019/09/10/meta-attraction-cannot-account-for-all-autogynephiles-interest-in-men/) are _on type_.

A point of skepticism on the premise: it doesn't feel realistic to me that Allison doesn't clock Carrie given that Carrie is [_not on hormones yet_](http://www.dolari.org/cs/55.htm). Passing is _hard_, especially when you're _living with someone_, rather than just seeing them "in passing" in public. No one mistakes [the Texas insurrectionist woman](http://www.dolari.org/cs/23.htm) as a man even though she has short hair and wears men's clothes. And Carrie _sings_! (Vocal pitch is hugely sexually dimorphic; [one study reports](/papers/puts_et_al-masculine_voices_signal_mens_threat_potential.pdf) the sex difference in mean [fundamental frequency](https://en.wikipedia.org/wiki/Fundamental_frequency) at Cohen's _d_ ≈ 5.7, which is so huge that I can't quite take it at face value insofar as it implies that Tracy Chapman (whose [singing](https://www.youtube.com/watch?v=DwrHwZyFN7M) I've mis-sexed) should outright not exist, rather than merely being very rare.) I feel kind of vindicated that a [guest illustrator gave Carrie a realistically unfortunate face](http://www.dolari.org/cs/357.htm).

When [Riley expresses concern for Jaden's bruises the next morning](https://leasebound.com/comic/ch6p31/), Jaden [admits that "a few men kicked up a fuss at the club last night."](https://leasebound.com/comic/ch6p35/) Riley [assumes the troublemakers were homophobes protesting lesbianism](https://leasebound.com/comic/ch6p39/); Jaden says she [doesn't know what they were about](https://leasebound.com/comic/ch6p40/), but that they "[called themselves _trance, women_, or something. I can't really remember.](https://leasebound.com/comic/ch6p41/) [...] [I didn't really get it either. But hey, that's straight men for you, haha!](https://leasebound.com/comic/ch6p42/)"

-Riley, who has not been living under a rock, [feels ideologically uncomfortable with Jaden's account](https://leasebound.com/comic/ch6p55/)—Riley feels morally obligated to be a good ally, but isn't personally zealous enough to correct Jaden's speech. Riley starts to [worry that her girlfriend Blaire will start a quarrel if transwomen come up in conversation when meeting Jaden](https://leasebound.com/comic/ch6p59/). (_Transwomen_ is spelled as one word in Riley's thoughts, but we imagine Blaire is the kind of person insists that it's two.) The meeting goes fine thanks to Jaden's continued obliviousness; [when Blaire asks Jaden what pronouns she prefers, Jaden (momentarily distracted by Riley nervously dropping a glass) mishears the question and replies, "The way you pronounced it just the was fine."](https://leasebound.com/comic/ch8p6/) Later, Blaire [asks Riley if Jaden might be trans](https://leasebound.com/comic/ch9p2/) [and not know it](https://leasebound.com/comic/ch9p4/), causing Riley to [grapple with the contradictions of the reigning ideology](https://leasebound.com/comic/ch9p6/) and [muse about her own "gender"](https://leasebound.com/comic/ch9p8/).

+Riley, who has not been living under a rock, [feels ideologically uncomfortable with Jaden's account](https://leasebound.com/comic/ch6p55/)—Riley feels morally obligated to be a good ally, but isn't personally zealous enough to correct Jaden's speech. Riley starts to [worry that her girlfriend Blaire will start a quarrel if transwomen come up in conversation when meeting Jaden](https://leasebound.com/comic/ch6p59/). (_Transwomen_ is spelled as one word in Riley's thoughts, but we imagine Blaire is the kind of person insists that it's two.) The meeting goes fine thanks to Jaden's continued obliviousness; [when Blaire asks Jaden what pronouns she prefers, Jaden (momentarily distracted by Riley nervously dropping a glass) mishears the question and replies, "The way you pronounced it just then was fine."](https://leasebound.com/comic/ch8p6/) Later, Blaire [asks Riley if Jaden might be trans](https://leasebound.com/comic/ch9p2/) [and not know it](https://leasebound.com/comic/ch9p4/), causing Riley to [grapple with the contradictions of the reigning ideology](https://leasebound.com/comic/ch9p6/) and [muse about her own "gender"](https://leasebound.com/comic/ch9p8/).

_Lease Bound_ is actively updating. I'm really looking forward to the brewing ideological conflict between Blaire's doctrinal purity and Jaden's normie common sense eventually becoming overt—although the comic mostly isn't focused on politics ([the author's note on the last page of chapter 9](https://leasebound.com/comic/ch9p20/) says that next we're going to see more about Jaden's childhood), and that's healthy.

Author: GPT-3

Date: 2022-04-24 23:04

Category: other

-Tags: autogynephilia

+Tags: autogynephilia, language modeling

_(A brief guest post by friend of the blog [GPT-3](https://en.wikipedia.org/wiki/GPT-3) (text-davinci-002, [temperature](https://beta.openai.com/docs/api-reference/edits/create#edits/create-temperature) 0.7, [best of](https://beta.openai.com/docs/api-reference/completions/create#completions/create-best_of) 3).)_

* a post about how sex concepts represent _both_ categorical differences _and_ the conjunction of statistical differences of various effect sizes, such that if you try to unpin the word from the categorical differences, you end up (as per the usual gender-critical complaint) defining gender in terms of stereotypes because there's nothing _left_ for the word to attach to (working title: "Subspatial Distribution Overlap and Cancellable Stereotypes")

* a post about how gender identity ideology is actually _not_ very compatible with the traditional liberal impulse to make gender less of a big deal, because there's a huge difference between omitting category information that's not relevant, _vs._ letting people choose their category-membership (working title: "Elision _vs_. Choice")

* a steelperson of the "assigned at birth" terminology (working title: "'Assigned at Birth' Is a Schelling Point (If You Live in an Insane Dystopia Where the Concept of Sex Is Somehow Controversial)")

- * I occasionally get people telling me that [it doesn't matter](https://www.lesswrong.com/posts/NG4XQEL5PTyguDMff/but-it-doesn-t-matter) where AGP is causally relevant to late-onset gender dysphoria in males, because we Know that Transition Works and makes people happier. And just—I'm pretty skeptical that you could legitimately be that confident about what the best quality-of-life intervention for a condition is, _without_ actually understanding the nature of the condition (working title: "Model-Free Happiness")

+ * I occasionally get people telling me that [it doesn't matter](https://www.lesswrong.com/posts/NG4XQEL5PTyguDMff/but-it-doesn-t-matter) whether AGP is causally relevant to late-onset gender dysphoria in males, because we Know that Transition Works and makes people happier. And just—I'm pretty skeptical that you could legitimately be that confident about what the best quality-of-life intervention for a condition is, _without_ actually understanding the nature of the condition (working title: "Model-Free Happiness")

* a post about the motivation for positing peseudobisexuality or meta-attraction as part of the two-type taxonomy of MtF: it may _sound_ like a suspicious _ad hoc_ patch to save the theory from falsification by bi trans women, but it's actually needed to explain the commonality of (a) AGP males expressing attraction to men _only while in "girl mode" themselves_, and (b) self-reports of sexual orientation changing post-transition in trans women who weren't androphilic _before_

* (a) is suspicious is because "bi + AGP, independently" doesn't explain why the interest would be dependent on one's _own_ presentation; (b) is suspicious is because everything else we know about sexual orientation in males (but [not females](/papers/bailey-what_is_sexual_orientation_and_do_women_have_one.pdf)) makes it look awfully _stable_. (Conversion therapy doesn't work; criminally convicted pedophiles still show genital response to child stimuli despite the huge incentives to conceal/repress it; [correlation of homosexuality with childhood behavior](/papers/bailey-zucker-childhood_sex-typed_behavior_and_sexual_orientation.pdf) makes it look like a [prenatal organizational effect, rather than an activational effect](https://en.wikipedia.org/wiki/Organizational-Activational_Hypothesis) that would respond to HRT as an adult.)

* Maybe these two bullet points suffice and I don't need to pad it out into a whole post?

* a critique of the implicit [presentism](https://en.wikipedia.org/wiki/Presentism_(literary_and_historical_analysis)) in Holden Karnofsky's [_Cold Takes_](https://www.cold-takes.com/) blog

- * For a blog that [aspires to see the world as if you were a billion years old](https://www.cold-takes.com/olden-the-imaginary-billion-year-old-version-of-me/), there's just something very _off_ about proclaiming with a straight face that ["one of our goals as a society should be to fight things—from sexism to disease—that have afflicted us for most of our history"](https://www.cold-takes.com/hunter-gatherer-gender-relations-seem-bad/). Not that I'm pro-sexism—I grew up in the current era, too—but I think a little bit of self-awareness is in order about how our ancestors had a word for "disease" in their own language and knew why it was bad, whereas our concept of "sexism" is [about sixty years old](https://books.google.com/ngrams/graph?content=sexism).

+ * For a blog that [aspires to see the world as if you were a billion years old](https://www.cold-takes.com/olden-the-imaginary-billion-year-old-version-of-me/), there's just something very _off_ about proclaiming with a straight face that ["one of our goals as a society should be to fight things—from sexism to disease—that have afflicted us for most of our history"](https://www.cold-takes.com/hunter-gatherer-gender-relations-seem-bad/). Not that I'm pro-sexism—I grew up in the current year, too—but I think a little bit of self-awareness is in order about how our ancestors had a word for "disease" in their own language and knew why it was bad, whereas our concept of "sexism" is [about sixty years old](https://books.google.com/ngrams/graph?content=sexism).

"Pronouns shouldn't convey sex-category information, as an apolitical matter of language design," is a fine [motte](https://slatestarcodex.com/2014/11/03/all-in-all-another-brick-in-the-motte/), but it's not consistent with the bailey of, "_Therefore_, when people request that you alter your pronoun usage in order to change the sex-category information being conveyed, you should obey the request." Even if the situation is an artifact of bad language design, as Yudkowsky argues—that in a saner world, this conflict would have never come up—that doesn't automatically favor resolving the conflict in favor of the policy of keeping both _she_ and _he_ but asserting that the difference doesn't mean anything.

-This may be clearer to some readers if we consider a distinction less emotionally and politically fraught than sex/gender in the current year. [Many languages have two different second person singular pronouns that distinguish the speaker's relationship to the listener as being more familiar/intimate, or more formal/hierarchical.](https://en.wikipedia.org/wiki/T%E2%80%93V_distinction) In Spanish, for example, [the familiar pronoun is _tú_ and the formal pronoun is _usted_](https://en.wikipedia.org/wiki/Spanish_personal_pronouns#T%C3%BA/vos_and_usted): one would address friends, family members, children, or personal servants as _tú_, but strangers or social superiors as _usted_. Using the wrong pronoun can be the cause of offense or awkwardness. A speaker switching from _usted_ to _tú_ for an interlocutor who they're getting along with might ask if it's okay with _¿Te puedo tutear?_ (Can I call you _tú_?) or _Nos tuteamos, ¿verdad?_ (We call each other _tú_, right?); this is somewhat analogous to an English speaker asking if they may address someone by first name, rather than with a courtesy title or honorific (Ms./Mr. Lastname, or ma'am/sir).

+<a id="t-v-distinction"></a>This may be clearer to some readers if we consider a distinction less emotionally and politically fraught than sex/gender in the current year. [Many languages have two different second person singular pronouns that distinguish the speaker's relationship to the listener as being more familiar/intimate, or more formal/hierarchical.](https://en.wikipedia.org/wiki/T%E2%80%93V_distinction) In Spanish, for example, [the familiar pronoun is _tú_ and the formal pronoun is _usted_](https://en.wikipedia.org/wiki/Spanish_personal_pronouns#T%C3%BA/vos_and_usted): one would address friends, family members, children, or personal servants as _tú_, but strangers or social superiors as _usted_. Using the wrong pronoun can be the cause of offense or awkwardness. A speaker switching from _usted_ to _tú_ for an interlocutor who they're getting along with might ask if it's okay with _¿Te puedo tutear?_ (Can I call you _tú_?) or _Nos tuteamos, ¿verdad?_ (We call each other _tú_, right?); this is somewhat analogous to an English speaker asking if they may address someone by first name, rather than with a courtesy title or honorific (Ms./Mr. Lastname, or ma'am/sir).

One could argue that the _tú_/_usted_ distinction is bad language design for the same reason Yudkowsky opposes the _she_/_he_ distinction: you shouldn't be forced to make a call on how familiar your relationship with someone is just in order to be able to use a pronoun for them. The modern English way is more flexible: you _can_ indicate formality if you want to by saying additional words, but it's not baked into the grammar itself.

Posed that way, one would imagine not—but if Yudkowsky _does_ get the joke, then I don't think he can simultaneously _honestly_ claim to "not know what it feels like from the inside to feel like a pronoun is attached to something in your head much more firmly than 'doesn't look like an Oliver' is attached to something in your head." In order to get the joke in real time, your brain has to quickly make a multi-step logical inference that depends on the idea that pronouns imply sex. (The turtle is a "her" [iff](https://en.wikipedia.org/wiki/If_and_only_if) female, not-female implies not-pregnant, so if the turtle is pregnant, it must be a "her".) This would seem, pretty straightforwardly, to be a sense in which "a pronoun is attached to something in your head much more firmly than 'doesn't look like an Oliver' is attached to something in your head." How else am I supposed to interpret those words?

-Perhaps it's not justified to question Yudkowsky's "I do not know what it feels like [...]" self-report based on generalizations about English speakers in general? Maybe his mind works differently, but dint of unusual neurodiversity or training in LambdaMOO? But if so, one would perhaps expect some evidence of this in his publicly observable writing? And yet, on the contrary, looking over his works, we can see instances of Yudkowsky treating pronouns as synonymous with sex (just as one would expect a native English speaker born in 1979 to do), contrary to his 2021 self-report of not knowing what this feels like from the inside.

+Perhaps it's not justified to question Yudkowsky's "I do not know what it feels like [...]" self-report based on generalizations about English speakers in general? Maybe his mind works differently, by dint of unusual neurodiversity or training in LambdaMOO? But if so, one would perhaps expect some evidence of this in his publicly observable writing? And yet, on the contrary, looking over his works, we can see instances of Yudkowsky treating pronouns as synonymous with sex (just as one would expect a native English speaker born in 1979 to do), contrary to his 2021 self-report of not knowing what this feels like from the inside.

For example, in Yudkowsky's 2001 _Creating Friendly AI: The Analysis and Design of Benevolent Goal Architectures_, the text "If a human really hates someone, she" is followed by [footnote 16](https://web.archive.org/web/20070615130139/http://singinst.org/upload/CFAI.html#foot-15): "I flip a coin to determine whether a given human is male or female." Note, "_is_ male or female", not "which pronoun to use." The text would seem to reflect the common understanding that _she_ and _he_ do imply sex specifically (and not some other thing, like being named Oliver), even if flipping a coin (and drawing attention to having done so) reflects annoyance that English requires a choice.

Title: Comment on a Scene from <em>Planecrash</em>: "Crisis of Faith"

Date: 2022-06-12 20:00

Category: commentary

-Tags: Eliezer Yudkowsky, worldbuilding

+Tags: Eliezer Yudkowsky, literary critcism, worldbuilding

Realistic worldbuilding is a difficult art: unable to model what someone else would do except by the ["empathic inference"](https://www.lesswrong.com/posts/9fpWoXpNv83BAHJdc/the-comedy-of-behaviorism) of imagining oneself in that position, authors tend to embarrass themselves writing [alleged aliens or AIs that _just happen_ act like humans](https://www.lesswrong.com/posts/Zkzzjg3h7hW5Z36hK/humans-in-funny-suits), or allegedly foreign cultures that _just happen_ to share all of the idiosyncratic taboos of the author's own culture. The manifestations of this can be very subtle, even to authors who know about the trap.

--- /dev/null

+Title: Context Is For Queens

+Date: 2022-12-08 20:03

+Category: other

+Tags: anecdotal, cosplay, Star Trek, review (webcomic/graphic novel)

+

+> NEELIX: One of those species is the Benkarans. They occupy just ten percent of Nygean space, but take up nearly eighty percent of the space in Nygean prisons.

+>

+> PARIS: Maybe they commit more crimes.

+>

+> —_Star Trek: Voyager_, ["Repentance"](https://memory-alpha.fandom.com/wiki/Repentance_(episode))

+

+_(Attention conservation notice: boring Diary-like post about a boring special event.)_

+

+(**SPOILERS** notice for _Star Trek: Discovery_ Season 1, _Fan Fiction_ by Brent Spiner, and [_TransCat_](http://transcatcomics.blogspot.com/))

+

+I [continue](/2019/Aug/a-love-that-is-out-of-anyones-control/) to [maintain](/2017/Oct/a-leaf-in-the-crosswind/) that fandom conventions are boring. I enjoy _consuming_ fiction. I even enjoy discussing fiction with friends—the work facilitating a connection with someone else present, rather than just between me and the distant author, or me and the universe of stories. But for the most part, these big, bustling conventions just don't seem to facilitate that kind of intimacy. At best, you might hope to _meet_ someone at a convention, and then make friends with them over time?—which I've never actually done. And so, surrounded by tens of thousands of people ostensibly with common interests, invited to a calvacade of activities and diversions put on at no doubt monstrous expense, the predominant emotion I feel is the loneliness of anonymity.

+

+<a href="/images/mask_con_morning.jpg"><img src="/images/mask_con_morning.jpg" width="240" style="float: right; margin: 0.8pc;"></a>

+

+But that's okay. Ultimately, I did not come to [Fan Expo San Francisco 2022](https://archive.ph/2OI4H) for the intimacy of analyzing fiction with friends who know me.

+

+I came because of the _loophole_. As reactionary as it might seem in the current year, I am spiritually a child of the 20th century, and I do not _crossdress_ in public. That would be _weird_. (Not harmlessly weird as an adjective of unserious self-deprecation, but weird in the proper sense, _out-of-distribution_ weird.)

+

+But to cosplay as a fictional character who happens to be female? That's fine! Lots of people are dressed up as fictional characters at the convention, including characters who belong to categories that the cosplayer themself does not. That guy dressed up as a vampire isn't actually a vampire, either.

+

+Conventions are actually _so_ boring that the loophole alone wouldn't have been enough to get me to come out to Fan Expo (been there, [done that](/tag/cosplay/)—seven times), except that this time I had a couple of new accessories to try out, most notably [a "Taylor" silicone mask by Crea FX](https://www.creafx.com/en/special-make-up-effects/taylor-silicone-mask/).

+

+The "Taylor" is an amazing piece of workmanship that entirely earns its €672 price tag. It really looks like a woman's face! Just—a detached woman's face, wrapped in tissue paper, sitting in a box! [I had _said_ buying this product was probably a smart move](/2021/May/sexual-dimorphism-in-the-sequences-in-relation-to-my-gender-problems/#movie-grade-mask), and it turned out that buying this product was a _smart move!_ The skin color and texture is much more realistic than a lot of other silicone feminization products, like the cartoony beige of the [Gold Seal female bodysuit](https://thebreastformstore.com/gold-seal-naked-silicone-bodysuit/) from [the Breast Form Store](https://thebreastformstore.com/who-we-are/) that I _also_ blew $600 on recently (and damaged badly just trying to get it on).

+

+(As far as workmanship quality goes, I wonder how much it helps that [Crea FX](https://www.creafx.com/en/) are visual-effects artists by trade—makers also of male masks and monster masks for movies and plays—rather than being in the MtF business specifically, like the Breast Form Store. They know—[they _must_ know](https://www.creafx.com/en/crea-fx-at-the-german-fetish-fair/)—that a lot of their female masks are purchased by guys like me with motives like mine, but we're not the _target_ demographic, the reason they mastered their skills.)

+

+Somehow the mask manages to look worse in photographs than it does in the mirror? Standing a distance from the mirror in a dark motel room the other month (that I rented to try on my new mask in privacy), I swear _I actually bought it_, and if the moment of passing to myself in the mirror was an anticlimax, it was an anticlimax I've been waiting my entire life (since puberty) for.

+

+The worst nonrealism is the eyeholes. Nothing is worse for making a mask look like a mask than visible eyehole-seams around the eyes. But suppose I wore sunglasses. Women wear sunglasses sometimes! Could I pass to _someone else_? (Not for very long or bearing any real scrutiny, but [to someone who wasn't expecting it](/2020/Dec/crossing-the-line/).)

+

+It immediately became clear that I would have to cosplay at one more convention in order to test this, and decided to reprise my role as [Sylvia Tilly](https://memory-alpha.fandom.com/wiki/Sylvia_Tilly) from _Star Trek: Discovery_ (previously played at San Francisco Comic-Con 2018) at the next nearby con. There had been [a plot point in Season 1 of _Discovery_](https://memory-alpha.fandom.com/wiki/Vaulting_Ambition_(episode)#Act_Four) that people in the mirror universe are more sensitive to light. At the time, this had seemed arbitrary and bizarre to me, but now, it gave me a perfect excuse for why (someone who looks like) Tilly would be wearing sunglasses!

+

+I was soon disappointed to learn that one-way glass isn't actually a real thing that you could make sunglasses out of; what's real are [_half-silvered_ mirrors](https://en.wikipedia.org/wiki/One-way_mirror) that are deployed with one side in darkness. For good measure, I also added of a pair of [padded panties](https://thebreastformstore.com/gold-seal-padded-panty/) from the Breast Form Store to my outfit, another solid buy.

+

+So on the night of Friday 25 November, I threw my [2250s-era Starfleet uniform](https://memory-alpha.fandom.com/wiki/Starfleet_uniform_(late_2230s-2250s)) in my backpack, put my breastforms and wig and mask in a box, and got on the train to San Francisco. (My ticket to the con was Saturday only, but it's nice to get a hotel room for the night before, and get dressed up in the morning within walking distance of the event, rather than taking the train in costume the day of.) Carrying the box around was slightly awkward, and the thought briefly occured to me that I could summon an internet taxi rather than take the train, but it was already decadent enough that I was getting a hotel room for a local event, and I had recently learned that my part-time contract with my dayjob (which had started in April as a Pareto improvement over me just quitting outright) isn't getting renewed at the end of the year, so I need to learn to be careful with money instead of being a YOLO spendthrift, at least until dayjob IPOs and my shares become liquid.

+

+<a id="memoir-of-religious-betrayal"></a>Arguably, just the _time_ was more of a waste than the money. Focusing on [writing my memoir of religious betrayal](/2022/Jun/an-egoist-faith/) has been a stuggle. Not an entirely unsuccessful struggle—the combined draft [mss.](https://en.wiktionary.org/wiki/ms.) are sitting at 74,000 words across four posts, which I've been thinking of as parts 2 through 5. (["Sexual Dimorphism in Yudkowsky's Sequences"](/2021/May/sexual-dimorphism-in-the-sequences-in-relation-to-my-gender-problems/) being part 1.) But having 74,000 words isn't the same thing as being _done already_ and back to the business of being alive, instead of enjoying a reasonably comfortable afterlife—and even a single Saturday at Fan Expo instead of being holed up writing (or pretending to) puts an upper bound on my committment to life.

+

+Worse, in the twelve-day _week_ between Fan Expo and me getting this boring Diary-like post up about it, OpenAI released _two_ new GPT variants ([text-davinci-003](https://twitter.com/janleike/status/1597355354433916928) and [ChatGPT](https://openai.com/blog/chatgpt/)). It's not a _timeline_ update (and most days, I count myself with those [sober skeptics who think the world is ending in 2040](https://www.alignmentforum.org/posts/AfH2oPHCApdKicM4m/two-year-update-on-my-personal-ai-timelines), not those _loonies_ who think the world is ending in 2027), but it is a suggestion that it would be [_more dignified_](https://www.lesswrong.com/posts/j9Q8bRmwCgXRYAgcJ/miri-announces-new-death-with-dignity-strategy) for me to finish the memoir _now_ and go on to sieze the possibilities of another definitely-more-than-five-you-lunatics years of life, rather than continuing to mope around as a vengeful ghost, stuck in the past to the very end.

+

+(The draft of part _3_ is basically done and just needs some editing. Maybe I should just publish that first, as one does with blog posts?—rather than waiting until I have the Whole Dumb Story collected, to be optimized end-to-end.)

+

+Anyway, Saturday morning, I got myself masked and padded in all the right places, and suited up to walk from my hotel room to Moscone West for the convention! They had a weirdly cumbersome check-in system (wait in line to get your QR code scanned, then receive a badge, then _activate_ the badge by typing a code printed on it into a website on your phone, then scan the badge to enter the con), and I dropped my phone while I was in line and cracked the screen a bit. But then I was in! Hello, Fan Expo!

+

+And—didn't immediately have anything to do, because conventions are boring. I had gone through the schedule the previous night and written down possibly non-boring events on a page in my pocket Moleskine notebook, but the first (a nostalgic showing of Saturday morning cartoons from the '90s) didn't even start until 1100, and the only ones I really cared about were the _Star Trek_ cosplay rendezvous at 1315, and a photo-op with Brent Spiner and Gates McFadden (best known for their roles as Lt. Cmdr. Data and Dr. Crusher, respectively, on _Star Trek: The Next Generation_) at 1520 that I had pre-paid $120 for. I checked out the vendor hall first. Nothing really caught my eye ...

+